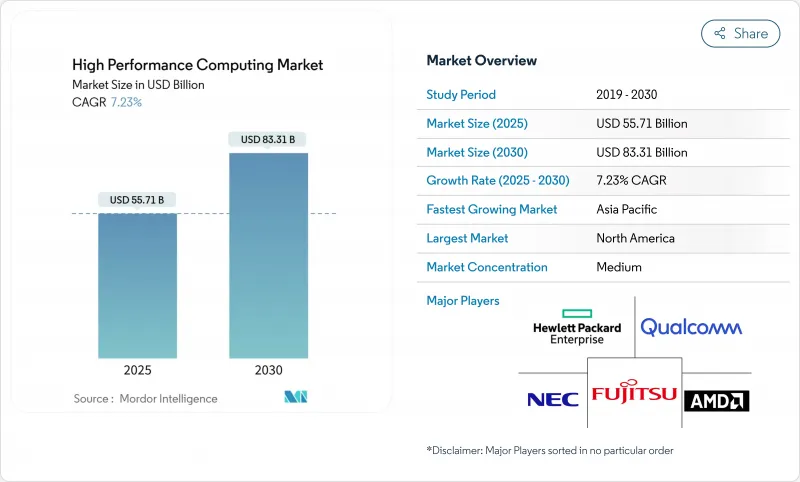

고성능 컴퓨팅 시장 규모는 2025년에 557억 달러, 2030년에는 833억 달러에 이르고, CAGR 7.23%로 성장할 것으로 예측됩니다.

기세는 순수한 과학 시뮬레이션에서 AI 중심의 워크로드로 이동하고 있기 때문에 물리 기반 코드를 실행하면서 기초 모델을 교육할 수 있는 GPU 리치 클러스터로 수요가 이행하고 있습니다. 소블린 AI 프로그램은 정부 구매자를 동일한 고속화 시스템을 요구하는 하이퍼스케일러와의 직접적인 경쟁으로 끌어들여 공급을 강화하고 고밀도 전력 엔벨로프를 제어하는 액체 냉각 아키텍처의 매력을 강화하고 있습니다. 하드웨어는 여전히 조달 예산의 중심이지만 관리 서비스와 HPC-as-a-Service는 예측할 수 없는 AI 수요 곡선과 일치하는 종량 과금 모델을 조직이 선호하기 때문에 빠르게 증가하고 있습니다. 병행하여 시장 성장 촉진요인으로는 하이브리드 도입의 확대, 생명과학 파이프라인의 가속, 데이터센터의 재설계를 강요하는 지속가능성의 의무화 등을 들 수 있습니다.

연방 정부 연구소는 현재 AI와 시뮬레이션의 혼합 용량을 중심으로 조달을 설계하고 있으며, 고성능 컴퓨팅 시장에서의 대응 가능한 피크 성능 수요는 실질적으로 두 배가 되고 있습니다. 보건복지성은 AI 대응 컴퓨팅을 2025년 연구 전략의 핵심으로 자리매김하고, 실험실에 엑사 스케일 시뮬레이션과 1조 파라미터 모델 트레이닝 사이를 오가는 GPU 고밀도 노드의 구입을 촉구하고 있습니다. 에너지부는 2025년도 AI-HPC 컨버전스에 11억 5,200만 달러를 확보했습니다. Tier-1 클라우드는 FIPS로 검증된 보안과 첨단 가속기를 결합한 소블린 AI 영역에서 지원하며, 업계 트래커는 2024년 상반기 AI 인프라 지출의 70%가 GPU 중심 설계에 사용되었다고 추정합니다. 그 결과 고성능 컴퓨팅 시장은 최상위 시스템 가치의 구조적 상승을 누리고 있지만, 부품 부족은 가격 변동을 높이고 있습니다. 공급업체는 현재 연방 정부의 상을 수상하기 위해 액체 냉각, 광 인터커넥트 및 제로 트러스트 펌웨어를 번들로 채널을 재구성하고 있습니다.

인도, 중국 및 일본의 계약 연구 기관은 리드 분자의 임상으로의 길을 단축하기 위해 DGX 클래스의 클러스터를 확장하고 있습니다. 미쓰이 물산과 NVIDIA가 2024년에 발표한 도쿄-1은 일본의 의약품 제조업체에 생체분자 워크로드에 맞춘 전용 H100 인스턴스를 제공합니다. 인도의 CRO 섹터는 2030년까지 연평균 복합 성장률(CAGR) 10.75%로 25억 달러에 달할 것으로 예측되고 있으며, 고전적인 다이내믹스에 AI를 활용한 타겟 식별을 거듭하여 클라우드 제공 슈퍼컴퓨팅에 대한 수요를 강화하고 있습니다. 연구원은 현재 GENESIS 소프트웨어를 사용하여 16억개의 원자를 시뮬레이션하고 대규모 단백질 상호작용을 탐구하기 시작했습니다. 이 능력은 탐색 아웃소싱에서 아시아태평양의 리더십을 지원하고 세계 가속기 공급 라인에서 아시아태평양의 견인력을 증폭시킵니다. 고성능 컴퓨팅 시장의 경우, 의약품 워크로드는 주기적인 제조 수요에 대한 반순환적인 헤지 역할을 합니다.

버지니아 주와 메릴랜드 주에서는 물 사용량의 공개를 의무화하는 법률이 제정되는 한편, 피닉스에서는 마이크로소프트의 제로 수냉을 시험적으로 도입해, 사이트 당 연간 1억 2,500만 리터의 절수를 실현하고 있습니다. 전력 회사는 현재 사업자가 액체 또는 후방 도어의 열교환을 약속하지 않는 한 메가와트의 새로운 연결을 제한하고 있습니다. 자본 지출은 15-20% 상승할 수 있으며, 고성능 컴퓨팅 시장에서는 수익이 압박되어 액침 시스템 또는 협조 공기 시스템으로의 전환이 촉진되고 있습니다. 따라서 콜드 플레이트 매니폴드와 유전체 공급업체는 레버리지를 받을 수 있습니다. 사업자는 더 시원한 기후 지역에 기반을 둡니다. 그러나 대기 시간과 데이터 주권 정책은 이전 옵션을 제한하기 때문에 이전이 아닌 설계 혁신으로 냉각수에 대한 긴장을 없애야 합니다.

2024년 고성능 컴퓨팅 시장 규모의 55.3%는 하드웨어가 차지했으며, 이는 서버, 인터커넥트 및 병렬 스토리지에 대한 지속적인 투자를 반영합니다. 그러나 매니지드 제공 제품은 CAGR 14.7%로 성장하고, CFO가 감가상각 자산보다 OPEX를 선호하게 되었기 때문에 조달 로직이 재구축되었습니다. 시스템 OEM은 클러스터가 노드 시간 단위로 청구되도록 계량 후크를 통합하여 하이퍼스케일 클라우드의 경제성을 반영합니다. AI 추론 파이프라인의 가속화로 예측 불가능한 버스트 수요가 발생하고 기업은 좌초 용량을 피하는 소비 모델로 이동합니다. Lenovo의 TruScale, Dell의 Apex, HPE의 GreenLake는 슈퍼 컴퓨팅 노드, 스케줄러 소프트웨어 및 서비스 수준 계약을 하나의 인보이스로 번들로 제공합니다. 벤더는 도입 사이클을 몇 개월에서 몇 주간 단축하는 턴키 액냉이나 광학계로 차별화를 도모하고 있습니다.

서비스의 기세는 미래의 가치가 상품 마더보드의 수가 아니라 오케스트레이션, 최적화, 보안 래퍼에 집중할 것임을 시사합니다. 유한 요소 분석 및 오믹스 워크로드를 마이그레이션하는 기업은 보조금 및 제조 이정표에 맞게 컴퓨팅 사용을 조정하는 투명한 작업 당 비용 계산을 높이 평가합니다. 또한 컴플라이언스 팀은 데이터를 On-Premise로 유지하면서 피크 시간에 공급자가 운영하는 별관 공간으로 유출할 수 있는 관리 서비스를 선호합니다. 이처럼 고성능 컴퓨팅 시장은 베어메탈 구매와 퍼블릭 클라우드의 완전 렌탈이 종착점이며, 고객 구내에서의 종량 과금이 중간점에 위치한 스펙트럼으로 이행하고 있습니다.

2024년 고성능 컴퓨팅 시장 점유율의 67.8%는 On-Premise 인프라가 차지하는데, 이는 미션 크리티컬한 코드에는 확정적인 레이턴시와 엄격한 데이터 거버넌스가 요구되기 때문입니다. 하지만 클라우드에 상주하는 클러스터는 2030년까지 연평균 복합 성장률(CAGR) 11.2%로 성장할 가속화된 인스턴스를 분 단위로 쉽게 대여할 수 있게 됩니다. 공유 주권 프레임워크를 통해 각 기관은 기밀 데이터 세트를 로컬 디스크에 유지하면서 익명화된 워크로드를 상용 클라우드로 버스트할 수 있습니다. CoreWeave는 OpenAI와 119억 달러의 5년 계약을 체결했으며, AI 클라우드에 특화된 클라우드가 퍼블릭 및 프라이빗 고객을 끌어들이고 있음을 보여주었습니다. 시스템 아키텍트는 현재 사이트간에 컨테이너를 원활하게 스테이징하는 소프트웨어 정의 패브릭을 설계하고 있습니다.

앞으로는 에지 캐시 노드, 로컬 액냉 랙, 임대 GPU 포드를 조합한 하이브리드형이 주류가 될 것으로 보입니다. Omnipath 및 Quantum-2 InfiniBand와 같은 상호 연결 추상화 기능을 통해 스케줄러는 물리적 위치를 무시하고 모든 가속기를 풀로 취급할 수 있습니다. 이 기능을 통해 워크로드 배치는 토폴로지가 아니라 비용, 보안 및 지속가능성에 의해 결정됩니다. 결과적으로 고성능 컴퓨팅 시장은 설비 투자보다 대역폭 경제성과 데이터 익스프레스 피를 조달 전략의 중심으로 하는 협력 자원 네트워크로 진화합니다.

에너지 효율적인 제조를 목적으로 한 HPC4EI 프로그램에 연방 정부 기관이 700만 달러를 투입했기 때문에 2024년 고성능 컴퓨팅 시장의 40.5%는 북미가 차지했습니다. CHIPS법은 4,500억 달러를 넘는 민간 팹의 헌신에 불을 붙여 2032년까지 세계 반도체 설비 투자의 28%를 차지하는 무대를 마련했습니다. 가뭄에 휩쓸리기 쉬운 주는 물에 의한 중립적인 냉각을 법제화하고 새로운 생산 능력을 액침이나 후방 도어의 액체 루프로 기울입니다. 하이퍼스케일러는 자체 설계 GPU 프로젝트를 가속화하고 지역 우위를 강화하지만 HBM 모듈의 현지 공급은 급박합니다.

아시아태평양의 CAGR은 9.3%로 가장 높지만, 이것은 주권 컴퓨팅 정책과 제약 아웃소싱 클러스터의 성장에 힘입은 것입니다. 중국의 통신 사업자는 주로 Inspur와 Huawei에서 17,000대의 AI 서버를 구매하려는 의도로 41억 달러의 국내 주문을 추가할 계획입니다. 인도의 9개 PARAM Rudra 장비와 향후 Krutrim AI 칩이 수직 통합 생태계를 구축할 예정입니다. 일본에서는 도쿄-1을 활용하여 국내 대형 의약품 제조업체의 임상 후보 스크리닝을 가속화하고 있습니다. 이러한 투자는 자본 인센티브와 현지 인력 및 규제 의무를 결합하여 고성능 컴퓨팅 시장 규모를 확대합니다.

유럽은 EuroHPC의 기세를 유지하고 LUMI(386 페타플롭스), Leonardo(249 페타플롭스), MareNostrum 5(215 페타플롭스)를 가동하고 JUPITER는 지역 최초의 엑서스케일 머신이 됩니다. Horizon Europe는 70억 유로(76억 달러)를 HPC와 AI 연구 개발에 투입하고 있습니다. 룩셈부르크의 공동 출자는 디지털 주권을 향한 산학 공동 설계를 추진합니다. 지역적인 전력 가격의 변동에 의해 운용 비용 억제를 위한 직접 액체 냉각과 재생에너지와의 채택을 가속화합니다. 남미, 중동, 아프리카는 아직 개발 도상이지만 지진 모델링, 기후 예측, 유전체학에 투자하고 있으며 모듈식 컨테이너 클러스터의 녹지 기회를 창출하고 있습니다.

The high-performance computing market size is valued at USD 55.7 billion in 2025 and is forecast to reach USD 83.3 billion by 2030, advancing at a 7.23% CAGR.

Momentum is shifting from pure scientific simulation toward AI-centric workloads, so demand is moving to GPU-rich clusters that can train foundation models while still running physics-based codes. Sovereign AI programs are pulling government buyers into direct competition with hyperscalers for the same accelerated systems, tightening supply and reinforcing the appeal of liquid-cooled architectures that tame dense power envelopes. Hardware still anchors procurement budgets, yet managed services and HPC-as-a-Service are rising quickly as organizations prefer pay-per-use models that match unpredictable AI demand curves. Parallel market drivers include broader adoption of hybrid deployments, accelerated life-sciences pipelines, and mounting sustainability mandates that force datacenter redesigns.

Federal laboratories now design procurements around mixed AI and simulation capacity, effectively doubling addressable peak-performance demand in the high-performance computing market. The Department of Health and Human Services framed AI-ready compute as core to its 2025 research strategy, spurring labs to buy GPU-dense nodes that pivot between exascale simulations and 1-trillion-parameter model training. The Department of Energy secured USD 1.152 billion for AI-HPC convergence in FY 2025. Tier-1 clouds responded with sovereign AI zones that blend FIPS-validated security and advanced accelerators, and industry trackers estimate 70% of first-half 2024 AI-infrastructure spend went to GPU-centric designs. The high-performance computing market consequently enjoys a structural lift in top-end system value, but component shortages heighten pricing volatility. Vendors now bundle liquid cooling, optical interconnects, and zero-trust firmware to win federal awards, reshaping the channel.

Contract research organizations in India, China, and Japan are scaling DGX-class clusters to shorten lead molecules' path to the clinic. Tokyo-1, announced by Mitsui & Co. and NVIDIA in 2024, offers Japanese drug makers dedicated H100 instances tailored for biomolecular workloads. India's CRO sector, projected to reach USD 2.5 billion by 2030 at a 10.75% CAGR, layers AI-driven target identification atop classical dynamics, reinforcing demand for cloud-delivered supercomputing. Researchers now push GENESIS software to simulate 1.6 billion atoms, opening exploration for large-protein interactions. That capability anchors regional leadership in outsourced discovery and amplifies Asia-Pacific's pull on global accelerator supply lines. For the high-performance computing market, pharma workloads act as a counter-cyclical hedge against cyclic manufacturing demand.

Legislation in Virginia and Maryland forces disclosure of water draw, while Phoenix pilots Microsoft's zero-water cooling that saves 125 million liters per site each year. Utilities now limit new megawatt hookups unless operators commit to liquid or rear-door heat exchange. Capital outlays can climb 15-20%, squeezing return thresholds in the high-performance computing market and prompting a shift toward immersion or cooperative-air systems. Suppliers of cold-plate manifolds and dielectric fluids therefore gain leverage. Operators diversify sites into cooler climates, but latency and data-sovereignty policies constrain relocation options, so design innovation rather than relocation must resolve the cooling-water tension.

Other drivers and restraints analyzed in the detailed report include:

For complete list of drivers and restraints, kindly check the Table Of Contents.

Hardware accounted for 55.3% of the high-performance computing market size in 2024, reflecting continued spend on servers, interconnects, and parallel storage. Managed offerings, however, posted a 14.7% CAGR and reshaped procurement logic as CFOs favor OPEX over depreciating assets. System OEMs embed metering hooks so clusters can be billed by node-hour, mirroring hyperscale cloud economics. The acceleration of AI inference pipelines adds unpredictable burst demand, pushing enterprises toward consumption models that avoid stranded capacity. Lenovo's TruScale, Dell's Apex, and HPE's GreenLake now bundle supercomputing nodes, scheduler software, and service-level agreements under one invoice. Vendors differentiate through turnkey liquid cooling and optics that cut deployment cycles from months to weeks.

Services' momentum signals that future value will center on orchestration, optimization, and security wrappers rather than on commodity motherboard counts. Enterprises migrating finite-element analysis or omics workloads appreciate transparent per-job costing that aligns compute use with grant funding or manufacturing milestones. Compliance teams also prefer managed offerings that keep data on-premise yet allow peaks to spill into provider-operated annex space. The high-performance computing market thus moves toward a spectrum where bare-metal purchase and full public-cloud rental are endpoints, and pay-as-you-go on customer premises sits in the middle.

On-premise infrastructures held 67.8% of the high-performance computing market share in 2024 because mission-critical codes require deterministic latency and tight data governance. Yet cloud-resident clusters grow at 11.2% CAGR through 2030 as accelerated instances become easier to rent by the minute. Shared sovereignty frameworks let agencies keep sensitive datasets on local disks while bursting anonymized workloads to commercial clouds. CoreWeave secured a five-year USD 11.9 billion agreement with OpenAI, signalling how specialized AI clouds attract both public and private customers. System architects now design software-defined fabrics that re-stage containers seamlessly between sites.

Hybrid adoption will likely dominate going forward, blending edge cache nodes, local liquid-cooled racks, and leased GPU pods. Interconnect abstractions such as Omnipath or Quantum-2 InfiniBand allow the scheduler to ignore physical location, treating every accelerator as a pool. That capability makes workload placement a policy decision driven by cost, security, and sustainability rather than topology. As a result, the high-performance computing market evolves into a network of federated resources where procurement strategy centers on bandwidth economics and data-egress fees rather than capex.

The High Performance Computing Market is Segmented by Component (Hardware, Software and Services), Deployment Mode (On-Premise, Cloud, Hybrid), Industrial Application (Government and Defense, Academic and Research Institutions, BFSI, Manufacturing and Automotive Engineering, and More), Chip Type (CPU, GPU, FPGA, ASIC / AI Accelerators) and Geography. The Market Forecasts are Provided in Terms of Value (USD).

North America commanded 40.5% of the high-performance computing market in 2024 as federal agencies injected USD 7 million into the HPC4EI program aimed at energy-efficient manufacturing. The CHIPS Act ignited over USD 450 billion of private fab commitments, setting the stage for 28% of global semi capex through 2032. Datacenter power draw may climb to 490 TWh by 2030; drought-prone states therefore legislate water-neutral cooling, tilting new capacity toward immersion and rear-door liquid loops. Hyperscalers accelerate self-designed GPU projects, reinforcing regional dominance but tightening local supply of HBM modules.

Asia-Pacific posts the strongest 9.3% CAGR, driven by sovereign compute agendas and pharma outsourcing clusters. China's carriers intend to buy 17,000 AI servers, mostly from Inspur and Huawei, adding USD 4.1 billion in domestic orders. India's nine PARAM Rudra installations and upcoming Krutrim AI chip build a vertically integrated ecosystem. Japan leverages Tokyo-1 to fast-track clinical candidate screening for large domestic drug makers. These investments enlarge the high-performance computing market size by pairing capital incentives with local talent and regulatory mandates.

Europe sustains momentum through EuroHPC, operating LUMI (386 petaflops), Leonardo (249 petaflops), and MareNostrum 5 (215 petaflops), with JUPITER poised as the region's first exascale machine. Horizon Europe channels EUR 7 billion (USD 7.6 billion) into HPC and AI R&D. Luxembourg's joint funding promotes industry-academia co-design for digital sovereignty. Regional power-price volatility accelerates adoption of direct liquid cooling and renewable matching to control operating costs. South America, the Middle East, and Africa are nascent but invest in seismic modeling, climate forecasting, and genomics, creating greenfield opportunities for modular containerized clusters.